Windows下使用laradock作为开发环境

本文共 1400 字,大约阅读时间需要 4 分钟。

Windows下使用laradock作为开发环境

关于laradock

- laradock是laravel官方维护的一个用于php开发docker集成环境 预先打包的Docker镜像,所有配置官方基本提供了。

- Laradock是在laravel社区众所周知的,因为这个项目最开始只关注在Docker上运行的laravel项目。后来,由于PHP社区的大量使用,它开始支持比如Symfony、CodeIgniter、WordPress、Drupal等其他的PHP项目。

我的个人用例

- 即使在windows下它依然是我平台开发的主要环境,基于学习docker都有比较好的帮助,我也是去年开始学习并使用docker。并在实际的业务场景中基于laradock给客户部署过一套php相关的项目,也基于客户内网部署过一套docker lnmp环境 ,使用和了解它,使我大大缩减了大部分部署相关环境消耗的时间:

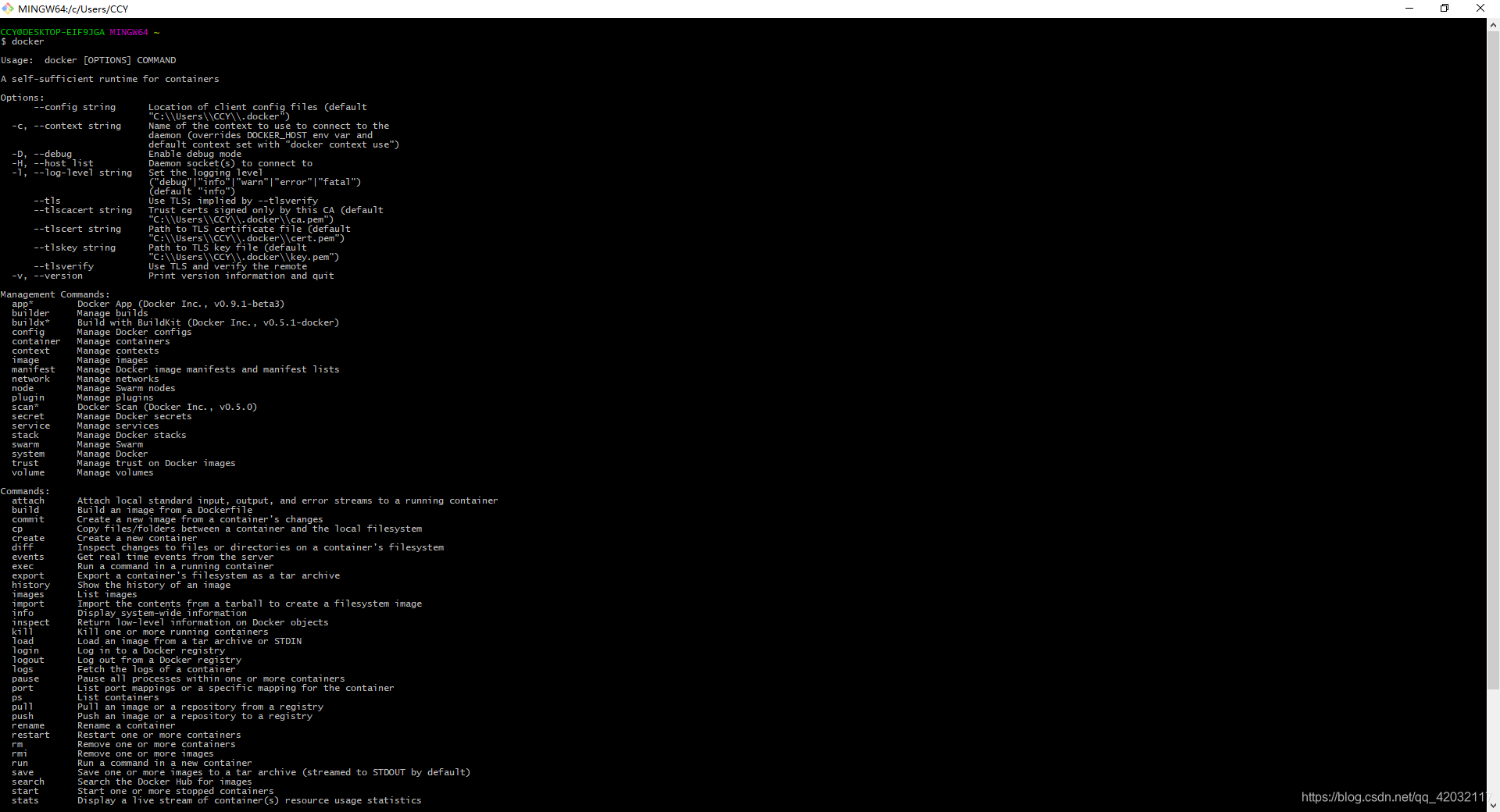

开始安装docker

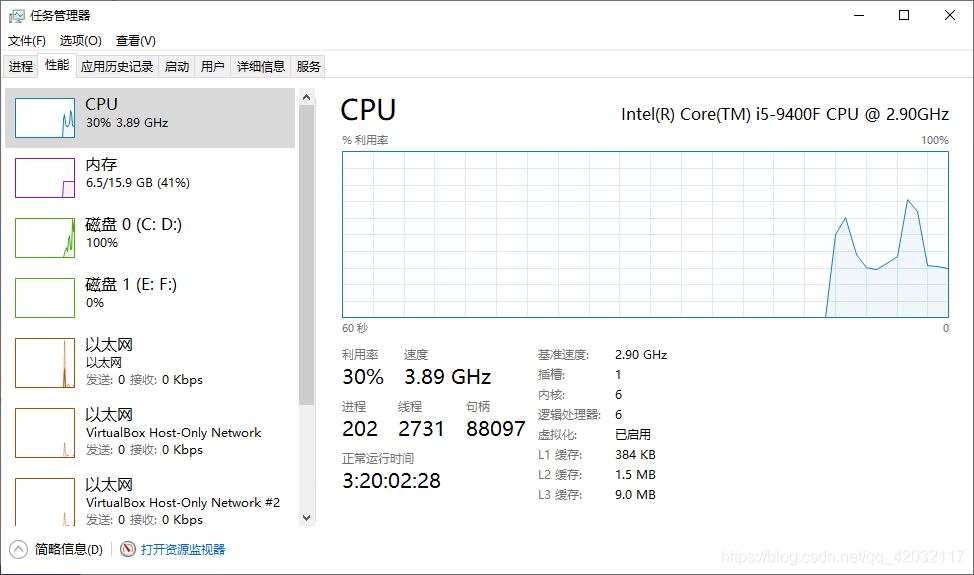

- 安装完成并开启虚拟化

启动异常问题

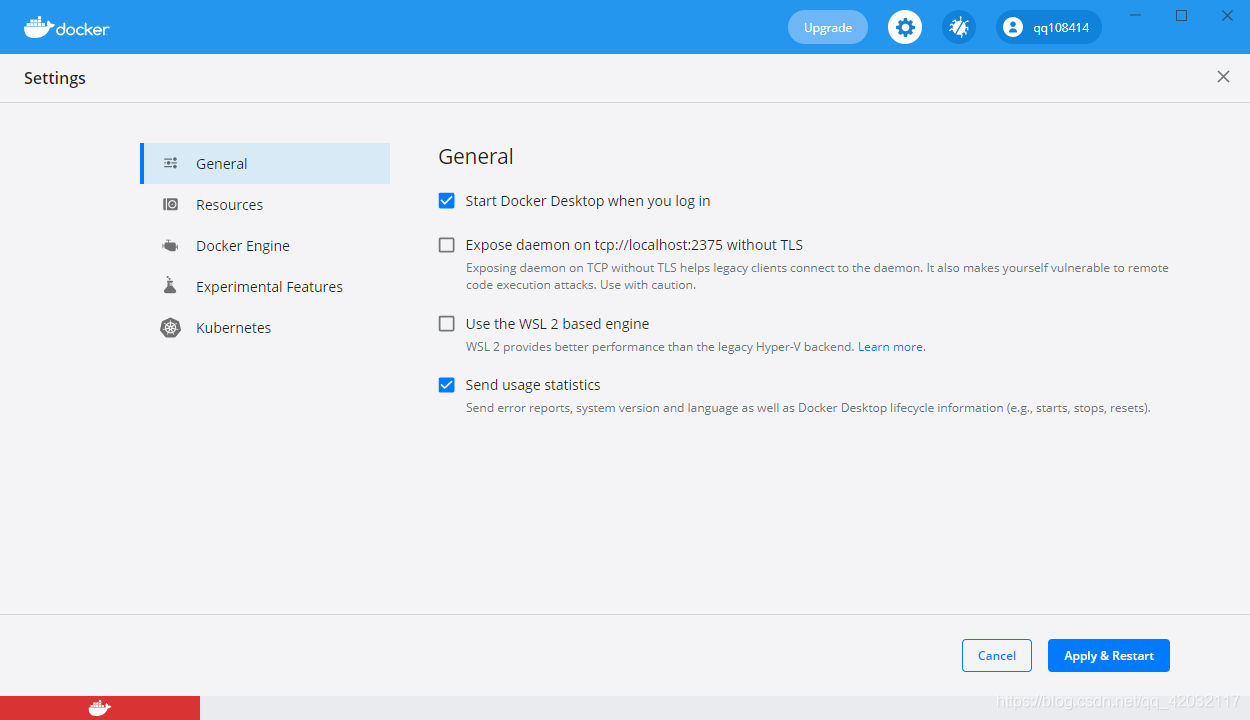

- 关闭USE 我们使用git工具作为命令行操作面板

- 登录docker账号 这个在官网注册一个

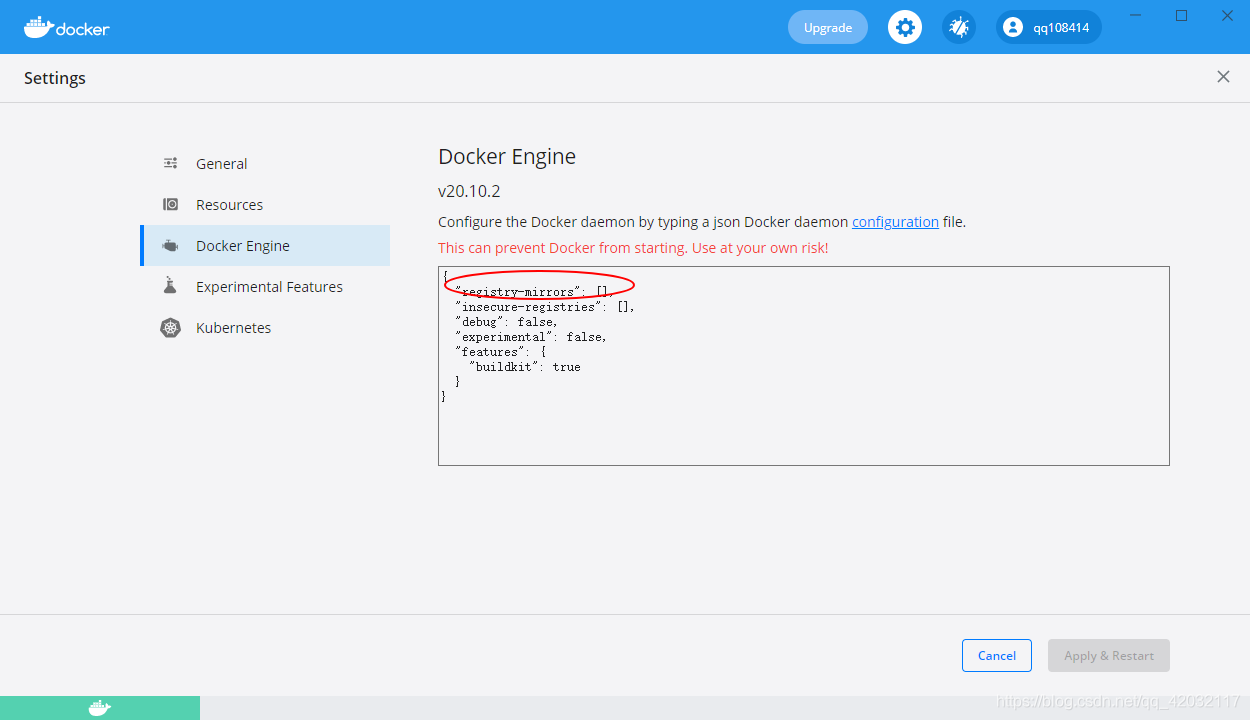

- 设置一个镜像源 有服务器的同学可以在自己服务器平台创建一个 或者

开始构建镜像

- 我们在E盘或者D盘创建一个WWW目录用于存放我们的项目

- 建议使用我这个地址 速度快的起飞。

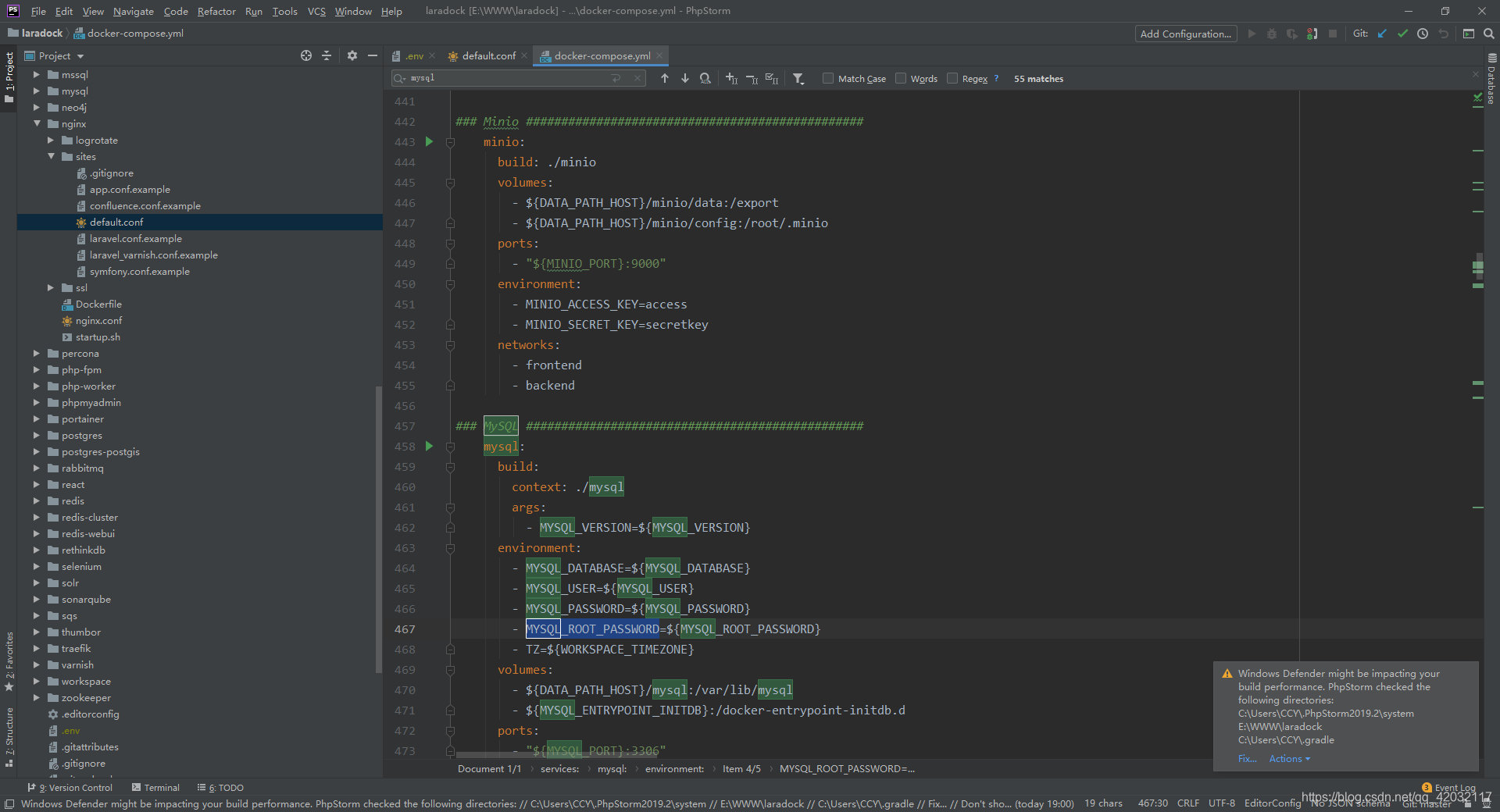

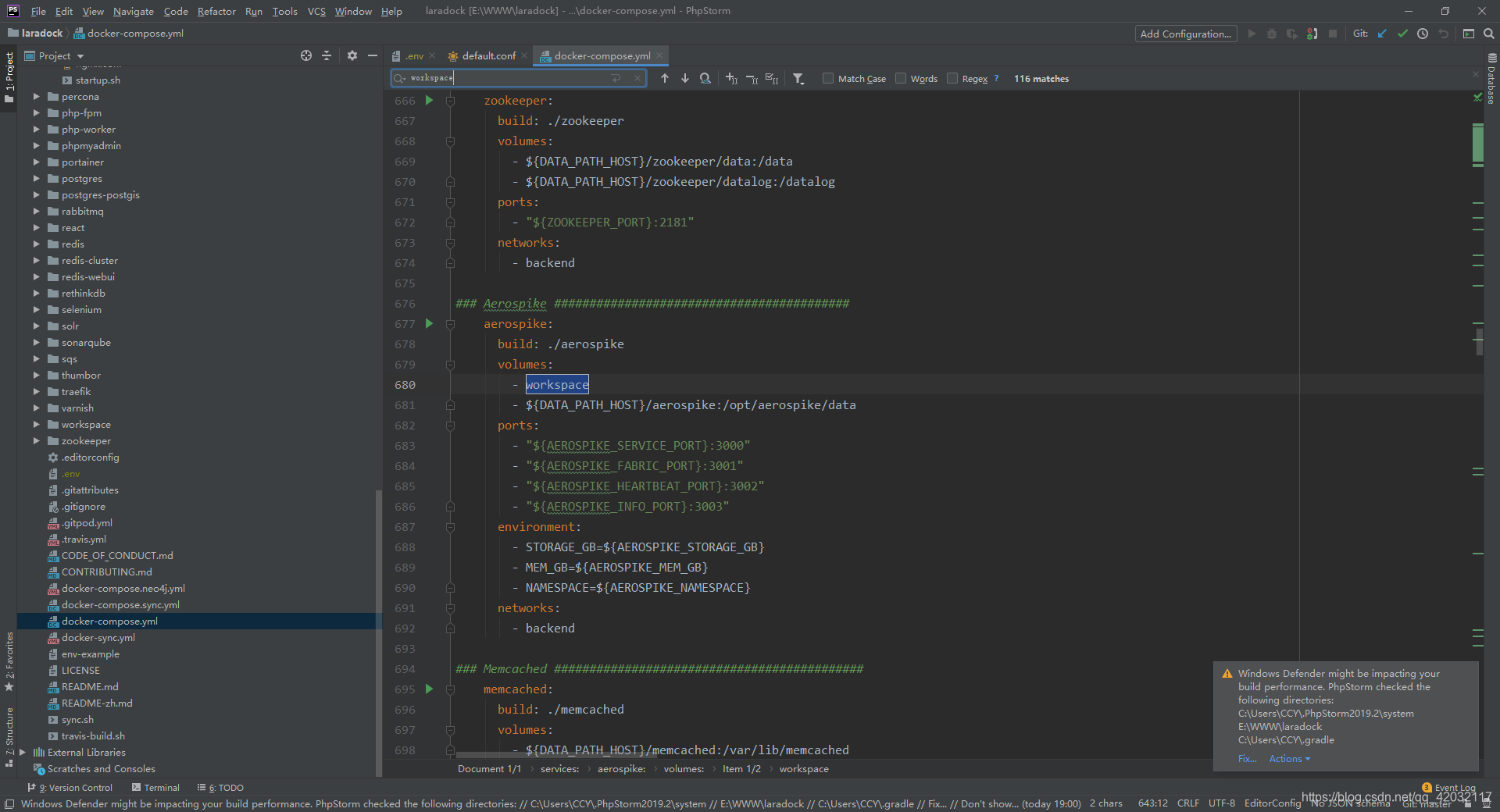

cd wwwgit clone https://gitee.com/pltrue/laradockcd laradockcp env-example .envvim .env//修改文件mysql版本MYSQL_VERSION=5.7//需要开启swooleWORKSPACE_INSTALL_SWOOLE=truePHP_FPM_INSTALL_SWOOLE=truePHP_WORKER_INSTALL_SWOOLE=trueWORKSPACE_INSTALL_SWOOLE=true//开始拉取需要的镜像 完成之后继续下一步 docker-compose build nginx php-fpm redis mysql //启动容器 docker-composer up -d nginx php-fpm redis mysql//进入某个容器winpty docker-composer exec redis bash //windows git下 记得带上命令 winpty//进入主容器 winpty docker-composer exec workspace bash//www 映射的是本地 laradock 同级目录 所有的项目都在/var/www 目录下面cd /var/www/

配置项目 nginx

- 在laradock/nginx/sites目录下配置nginx配置文件 php框架的模板都有

//配置好了之后,重启nginxwinpty docker-composer exec nginx bashnginx -s reload

- 注意 laradock容器之间通信不能通过127.0.0.1 而是通过名:例如:host:redis host:mysql

- 如果需要配置额外的端口与容器通信 在docker-compose.yml、和env中配置新端口 然后重新重建容器

- 之后所有操作都一样。其他具体可以查看官方文档。有问题,在本文下面提出,我会即时答复。

转载地址:http://mywaz.baihongyu.com/

你可能感兴趣的文章

ngModelController

查看>>

ngrok | 内网穿透,支持 HTTPS、国内访问、静态域名

查看>>

ngrok内网穿透可以实现资源共享吗?快解析更加简洁

查看>>

ngrok内网穿透可以实现资源共享吗?快解析更加简洁

查看>>

NHibernate学习[1]

查看>>

NHibernate异常:No persister for的解决办法

查看>>

Nhibernate的第一个实例

查看>>

nid修改oracle11gR2数据库名

查看>>

NIFI1.21.0/NIFI1.22.0/NIFI1.24.0/NIFI1.26.0_2024-06-11最新版本安装_采用HTTP方式_搭建集群_实际操作---大数据之Nifi工作笔记0050

查看>>

NIFI1.21.0_java.net.SocketException:_Too many open files 打开的文件太多_实际操作---大数据之Nifi工作笔记0051

查看>>

NIFI1.21.0_Mysql到Mysql增量CDC同步中_日期类型_以及null数据同步处理补充---大数据之Nifi工作笔记0057

查看>>

NIFI1.21.0_Mysql到Mysql增量CDC同步中_补充_插入时如果目标表中已存在该数据则自动改为更新数据_Postgresql_Hbase也适用---大数据之Nifi工作笔记0058

查看>>

NIFI1.21.0_Mysql到Mysql增量CDC同步中_补充_更新时如果目标表中不存在记录就改为插入数据_Postgresql_Hbase也适用---大数据之Nifi工作笔记0059

查看>>

NIFI1.21.0_NIFI和hadoop蹦了_200G集群磁盘又满了_Jps看不到进程了_Unable to write in /tmp. Aborting----大数据之Nifi工作笔记0052

查看>>

NIFI1.21.0_Postgresql和Mysql同时指定库_指定多表_全量同步到Mysql数据库以及Hbase数据库中---大数据之Nifi工作笔记0060

查看>>

NIFI1.21.0最新版本安装_连接phoenix_单机版_Https登录_什么都没改换了最新版本的NIFI可以连接了_气人_实现插入数据到Hbase_实际操作---大数据之Nifi工作笔记0050

查看>>

NIFI1.21.0最新版本安装_配置使用HTTP登录_默认是用HTTPS登录的_Https登录需要输入用户名密码_HTTP不需要---大数据之Nifi工作笔记0051

查看>>

NIFI1.21.0通过Postgresql11的CDC逻辑复制槽实现_指定表多表增量同步_增删改数据分发及删除数据实时同步_通过分页解决变更记录过大问题_02----大数据之Nifi工作笔记0054

查看>>

NIFI1.21.0通过Postgresql11的CDC逻辑复制槽实现_指定表多表增量同步_增加修改实时同步_使用JsonPath及自定义Python脚本_03---大数据之Nifi工作笔记0055

查看>>

NIFI1.21.0通过Postgresql11的CDC逻辑复制槽实现_指定表多表增量同步_插入修改删除增量数据实时同步_通过分页解决变更记录过大问题_01----大数据之Nifi工作笔记0053

查看>>